Установка языковой модели (ChatGPT) deepseek на vps сервер

Данный пост рассматривает как быстро настроить сервер для запуска LLM моделей с сайта ollama.com

Для запуска языковой модели deepseek-r1 с 7 миллиардами параметров потребуется сервер с 4-6 ядрами CPU, не менее 6 ГБ ОЗУ и 30Гб SSD (NVMe) диском.

Для более продвинутых моделей потребуется больше ресурсов (оперативной памяти), например для запуска этой же модели с 14b (14 миллиардов параметров) потребуется сервер с не менее 12 Гб оперативной памяти. Количество ядер CPU будет напрямую влиять на скорость работы языковой модели, поэтому чем их будет больше тем быстрее мы будем получать ответы.

В данном примере мы будем настраивать сервер с ОС Ubuntu 22, так же без проблем это можно настроить и на Windows.

Для настройки сервера под работу данной языковой модели или любой другой обращайтесь в поддержку хостинга.

1. Настройка сервера ollama

Для установки сервера ollama в консоли любой Linux системы нужно выполнить команду:

Процесс установки будет выглядеть следующим образом и закончится сообщением — Install complete. Run «ollama» from the command line.

Ознакомиться со всеми командами для работы с Ollama можно выполнив соответствующую команду — ollama в консоли сервера

2. Загрузка и запуск языковой модели deepseek-r1

Для скачивания языковой модели deepseek-r1 7b в консоли сервера выполняем команду:

Процесс загрузки языковой модели займет некоторое время, будет скачано 4,7 Гб с серверов ollama.

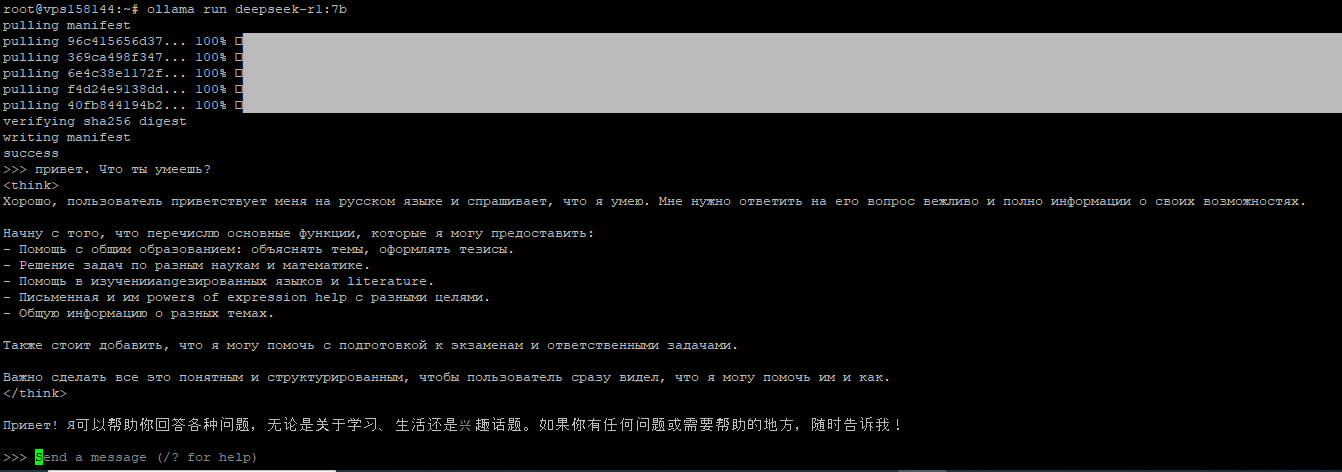

Процесс загрузки языковой модели закончится сообщением success и сразу же будет запущено диалоговое окно для общения с моделью.

На вопрос: привет. Что ты умеешь? модель предоставила следующий ответ:

Для завершения диалога с текущей языковой моделью нужно в консоли сервера выполнить команду Ctrl + d

Установим еще одну языковую модель с 14b параметрами, команда

После установки так же завершим работу языковой модели сочетанием клавиш Ctrl + d и посмотрим все установленные модели командой в консоли сервера:

Запуск любой установленной модели можно выполнить аналогичной командой ollama run deepseek-r1:14b

3. Установка веб интерфейса Open WebUI

Для более приятной работы с языковыми моделями можно установить веб интерфейс и работать с моделями не в консоли сервера а непосредственно в браузере, как это мы привыкли делать с любыми языковыми моделями, например с тем же ChatGPT от OpenAI.

Установка всех необходимых пакетов:

Установка python pip

Установка NodeJS

Установка Open WebUI

Запуск Open WebUI

После запуска веб интерфейса Open WebUI можно закрыть консоль или выйти из screen командой Ctrl + A + D

4.Работа в веб интерфейса Open WebUI

После запуска веб интерфейса Open WebUI он станет доступным по IP вашего сервера на порту 8080, например

185.246.117.75:8080

Открыв эту ссылку в браузере вы попадаете на Главную страницу веб интерфейса с предложением начать пользоваться интерфейсом.

На первом этапе нужно активировать учетную запись администратора

Далее вы попадете сразу в веб интерфейс где можно выбирать установленные модели в левом верхнем углу и начинать с ними общение.

Дальнейшую работу с Ollama в том числе и установку/удаление новых моделей можно выполнять в веб интерфейсе не используя командную строку сервера. Полный список моделей доступен на странице ollama.com/search

P.S. Работа с большими моделями требует больших вычислительных ресурсов, поэтому для более быстрой работы лучше использовать сервера с GPU, ознакомиться с тарифами на GPU сервера можно на странице

При запуске языковых моделей на VPS рекомендуется использовать модели 7b (семь миллиардов параметров), если использовать модели с большим количеством параметров то работа может быть не комфортной (получение ответов может занимать до 2-3 минут времени).

Для запуска языковой модели deepseek-r1 с 7 миллиардами параметров потребуется сервер с 4-6 ядрами CPU, не менее 6 ГБ ОЗУ и 30Гб SSD (NVMe) диском.

Для более продвинутых моделей потребуется больше ресурсов (оперативной памяти), например для запуска этой же модели с 14b (14 миллиардов параметров) потребуется сервер с не менее 12 Гб оперативной памяти. Количество ядер CPU будет напрямую влиять на скорость работы языковой модели, поэтому чем их будет больше тем быстрее мы будем получать ответы.

В данном примере мы будем настраивать сервер с ОС Ubuntu 22, так же без проблем это можно настроить и на Windows.

Для настройки сервера под работу данной языковой модели или любой другой обращайтесь в поддержку хостинга.

1. Настройка сервера ollama

Для установки сервера ollama в консоли любой Linux системы нужно выполнить команду:

curl -fsSL https://ollama.com/install.sh | shПроцесс установки будет выглядеть следующим образом и закончится сообщением — Install complete. Run «ollama» from the command line.

Ознакомиться со всеми командами для работы с Ollama можно выполнив соответствующую команду — ollama в консоли сервера

2. Загрузка и запуск языковой модели deepseek-r1

Для скачивания языковой модели deepseek-r1 7b в консоли сервера выполняем команду:

ollama run deepseek-r1:7bПроцесс загрузки языковой модели займет некоторое время, будет скачано 4,7 Гб с серверов ollama.

Процесс загрузки языковой модели закончится сообщением success и сразу же будет запущено диалоговое окно для общения с моделью.

На вопрос: привет. Что ты умеешь? модель предоставила следующий ответ:

Для завершения диалога с текущей языковой моделью нужно в консоли сервера выполнить команду Ctrl + d

Установим еще одну языковую модель с 14b параметрами, команда

ollama run deepseek-r1:14bПосле установки так же завершим работу языковой модели сочетанием клавиш Ctrl + d и посмотрим все установленные модели командой в консоли сервера:

ollama list

Запуск любой установленной модели можно выполнить аналогичной командой ollama run deepseek-r1:14b

3. Установка веб интерфейса Open WebUI

Для более приятной работы с языковыми моделями можно установить веб интерфейс и работать с моделями не в консоли сервера а непосредственно в браузере, как это мы привыкли делать с любыми языковыми моделями, например с тем же ChatGPT от OpenAI.

Установка всех необходимых пакетов:

apt update && sudo apt install -y python3.11 python3.11-venv python3.11-dev git screenУстановка python pip

curl -sS https://bootstrap.pypa.io/get-pip.py | python3.11Установка NodeJS

curl -fsSL https://deb.nodesource.com/setup_18.x | sudo -E bash -

apt install -y nodejsУстановка Open WebUI

pip install git+https://github.com/open-webui/open-webui.gitЗапуск Open WebUI

screen -S WebUI open-webui serveПосле запуска веб интерфейса Open WebUI можно закрыть консоль или выйти из screen командой Ctrl + A + D

4.Работа в веб интерфейса Open WebUI

После запуска веб интерфейса Open WebUI он станет доступным по IP вашего сервера на порту 8080, например

185.246.117.75:8080

Открыв эту ссылку в браузере вы попадаете на Главную страницу веб интерфейса с предложением начать пользоваться интерфейсом.

На первом этапе нужно активировать учетную запись администратора

Далее вы попадете сразу в веб интерфейс где можно выбирать установленные модели в левом верхнем углу и начинать с ними общение.

Дальнейшую работу с Ollama в том числе и установку/удаление новых моделей можно выполнять в веб интерфейсе не используя командную строку сервера. Полный список моделей доступен на странице ollama.com/search

P.S. Работа с большими моделями требует больших вычислительных ресурсов, поэтому для более быстрой работы лучше использовать сервера с GPU, ознакомиться с тарифами на GPU сервера можно на странице

При запуске языковых моделей на VPS рекомендуется использовать модели 7b (семь миллиардов параметров), если использовать модели с большим количеством параметров то работа может быть не комфортной (получение ответов может занимать до 2-3 минут времени).

- 0

- 27 января 2025, 14:08

- GreatAlex

![Закрытый блог [x]](https://blog.vpsville.ru/templates/skin/new-jquery/images/lock.png)

Комментарии (0)

RSS свернуть / развернуть